Interview mit Dr. Isabell Wochner, Juni 2025

Wir haben menschliche Bewegungen noch immer nicht verstanden

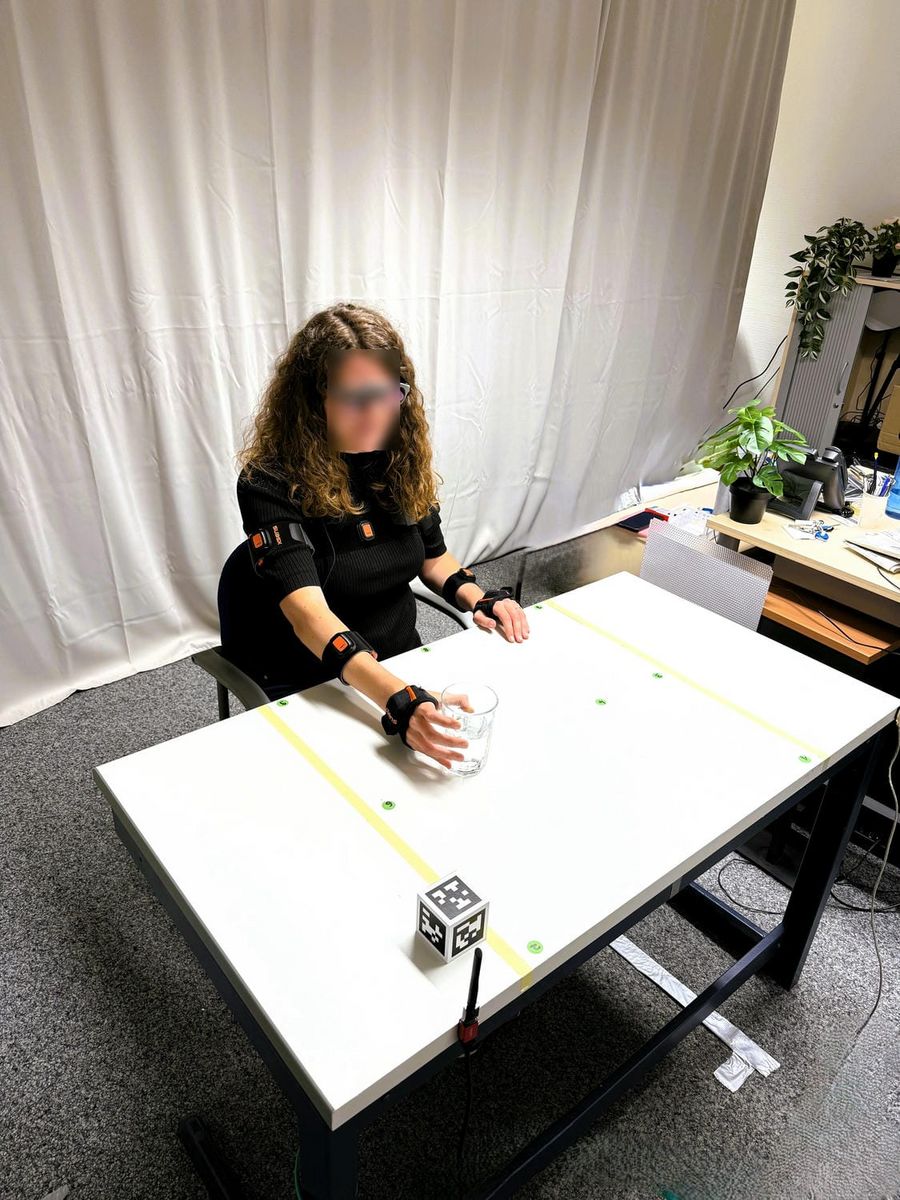

Dr. Isabell Wochner erforscht am Hertie-Institut in Tübingen, wie Alltagshandlungen wie das Greifen nach einem Glas Wasser vorhergesagt und durch robotische Assistenzsysteme unterstützt werden können. Mithilfe tragbarer Sensoren, physikbasierter KI und neuromechanischer Modelle will sie Bewegungsabläufe in Echtzeit rekonstruieren – um Menschen mit motorischen Einschränkungen zu helfen. Ihre Vision: Assistenzsysteme, die so intuitiv unterstützen wie ein smarter Pullover.

Was passiert eigentlich zwischen unserem Hirn und unseren Muskeln, wenn wir nach einem Glas Wasser greifen? Wie laufen Bewegungen genau ab? Damit beschäftigt sich Dr. Isabell Wochner, seit Februar 2025 Leiterin der unabhängigen Forschungsgruppe „Neuromechanische Modellierung und Sensorfusion für Assistenzrobotik“ am Hertie-Institut für klinische Hirnforschung in Tübingen (HIH). Sie untersucht, wie Alltagsbewegungen mithilfe tragbarer Sensordaten und neuromechanischer Computermodelle in Echtzeit vorhergesagt werden können, um künftig Menschen mit Bewegungsstörungen besser unterstützen zu können. Worin die Herausforderungen bestehen – und was das alles mit einem Pullover zu tun hat, lesen Sie in unserem Interview.

Worum geht es bei Ihrer Arbeit genau, und welches Ziel verfolgen Sie?

Ich betreibe Grundlagenforschung und die beschäftigt sich damit, menschliche Bewegungen zu verstehen. Wie können wir Kontrollstrategien begreifen, mit denen Gehirn und Nervensystem gezielt Bewegungen planen und die Muskeln ansteuern? Das ist ein unglaublich komplexes System, das wir meiner Meinung nach noch immer nicht verstanden haben. Ein Beispiel: Wenn Menschen aufgefordert werden, nach einem Glas Wasser zu greifen, dann machen sie das alle auf eine ganz besondere Art und Weise. Diese zu verstehen, fasziniert mich. Konkret bedeutet das für meine Forschungsgruppe: Wir untersuchen, wie Alltagsbewegungen mithilfe einer Kombination aus Sensordaten, die die Blick- und Körperbewegungen erfassen, und neuromechanischen Computermodellen vorhergesagt werden können – und zwar in Echtzeit. Ziel ist es, durch eine verbesserte Vorhersage robotische Assistenzsysteme zu ermöglichen, die Menschen mit motorischen Beeinträchtigungen unterstützen und somit ihre Lebensqualität erheblich verbessern. Ich greife also zu einem Glas Wasser, und diese Bewegung wird dann optimal durch das Assistenzsystem unterstützt.

"In meiner Forschung geht es vor allem darum, Bewegungen zu unterstützen – etwa bei Menschen mit einem Tremor oder Ataxie, also ein Überschießen oder Unterschießen der Bewegungen."

Wie muss man sich die Umsetzung praktisch vorstellen?

Man setzt sich eine Brille auf, und die misst dann die Augenbewegungen. Wenn ich nach einem Glas Wasser greifen möchte, ist es in der Regel so - vor allem auch bei Patienten und Patientinnen, deren Bewegungen verlangsamt sind – dass ich erst mal zu dem Wasserglas hinschaue und dann meine Bewegung starte in Richtung des Ziels. Genau das können die Brillen detektieren. Meine Forschung beschäftigt sich mit der Frage: Wie kann ich diese Sensordaten gemeinsam mit Computermodellen nutzen, um sicher vorherzusagen, wie der Bewegungsablauf möglichst reibungslos vonstatten geht?

Und diese mithilfe der Brille gesammelten Infos landen dann im Assistenzsystem?

Richtig, man muss jetzt bei den Assistenzsystemen ein bisschen unterscheiden: Es gibt zum Beispiel Exoskelette – also tragbare mechanische Assistenzsysteme – die eine Bewegung unterstützen. Dann gibt es Prothesen, die tatsächlich Körperteile ersetzen. Und schließlich gibt es Exoskelette, die die Bewegung für den Patienten ausführen sollen. In meiner Forschung geht es vor allem darum, Bewegungen zu unterstützen – etwa bei Menschen mit einem Tremor oder Ataxie, also ein Überschießen oder Unterschießen der Bewegungen. Dann soll diese unerwünschte Bewegung durch das Assistenzsystem ausgeglichen werden, sodass die eigentliche Bewegung stattfinden kann.

Das klingt knifflig. Was sind die Herausforderungen?

Es gibt zum einen technische Herausforderungen, also bezüglich der Sensoren. Wir wollen kleine, tragbare Sensoren einsetzen, die Bewegungen synchron aufnehmen und die Daten miteinander fusionieren. Da spielt dann auch eine intensive Rechenleistung eine Rolle, damit das Ergebnis sehr effizient berechnet werden kann. In Echtzeit natürlich, denn es bringt mir nichts, wenn ich auf das Glas schaue und die entsprechende Bewegung eine Minute später berechnet wird. Eine weitere Herausforderung ist es, das System so zu bauen, dass es zuverlässig funktioniert – auch dann, wenn es mal schwieriger wird, etwa durch Störungen oder ungenaue Daten. Daneben gibt es wissenschaftliche Fragen, die noch nicht gelöst sind: Wir haben menschliche Bewegungen immer noch nicht so gut verstanden, dass wir zum Beispiel Roboter bauen können, die sich wirklich wie Menschen bewegen. Wie genau funktioniert dieses Zusammenspiel zwischen Steuerung im Gehirn und Muskelbewegung? Das ist immer noch eine große Frage.

Sie sind seit Februar 2025 am HIH. Welche besonderen Bedingungen bietet das Institut für Ihre Forschung?

Ich bin eine sehr interdisziplinäre Wissenschaftlerin und auch meine Gruppe ist sehr interdisziplinär. In der Vergangenheit war ich in der Ingenieursfakultät, dann in der Informatik und jetzt bin ich am HIH. Das Besondere ist hier, dass es diesen klinischen Fokus mit Verknüpfung zu Neurotechnologien gibt. Es ist für mich super faszinierend, dass durch den Austausch mit den klinischen Wissenschaftlerinnen und Wissenschaftlern meiner Gruppe ermöglicht wird, mit Patientinnen und Patienten zu arbeiten und dadurch die damit verbundenen Herausforderungen besser zu verstehen.

Sie arbeiten auch mit Künstlicher Intelligenz – inwieweit kann KI Ihnen eine Hilfe sein?

KI bietet uns die Chance, dass wir aus den Daten abstrakte Modelle ermitteln können. Bei mir in der Forschung ist es allerdings sehr wichtig, dass das nicht eine reine KI ist, sondern eine physikbasierte KI. Das heißt, dass zusätzlich immer noch physikalische Modelle integriert sind, die bestimmte Gesetzmäßigkeiten der Physik berücksichtigen. Denn einerseits haben wir, wenn wir mit den Patientinnen und Patienten arbeiten, nicht so viele Daten, die wir bräuchten für eine rein KI-basierte Lösung. Das andere ist, dass uns das Modell zusätzliche Garantien gibt: Wenn ich mit meinem Assistenzsystem zum Beispiel in einen für mich ungeschickten Gelenkwinkel geraten würde, dann würde die physikbasierte KI das vorher errechnen und das Modell würde sagen: „Nein, das ist physikalisch nicht möglich“. Wir haben also immer noch physikalische Einschränkungen, aber trotzdem die KI, um aus Daten abstrakte Modelle zu gewinnen.

Arbeiten Sie in Sachen KI und Maschinelles Lernen auch mit dem Hertie AI zusammen?

Da wird es künftig sicher einige Überschneidungen geben. Im Moment ist bei mir alles noch im Aufbau, aber das Cyber Valley als Europas größte Forschungskooperation auf dem Gebiet der künstlichen Intelligenz, das hier in der Region Tübingen-Stuttgart angesiedelt ist – das ist natürlich ein tolles Umfeld für mich. Maschinelles Lernen, Computer Vision und Robotik werden durch das Land Baden-Württemberg sowie durch andere Institutionen gefördert. Meine Nachwuchsgruppe am HIH wird zum Beispiel durch Drittmittel von der Carl-Zeiss-Stiftung unterstützt.

Wie schätzen Sie den Markt der Assistenzsysteme ein – worauf können Menschen mit Bewegungsstörungen hoffen?

Es gibt viele Kollaborationen und natürlich noch andere Forschende, die außer mir direkt solche Systeme entwickeln. Das ist superspannend zu sehen und es gibt auch schon Anwendungen, aber ich würde jetzt nicht sagen, dass es da schon etwas auf dem Markt gibt, was man tatsächlich kaufen kann. Einfach, weil es diese Herausforderungen gibt. Die Kontrolle solcher Systeme ist noch nicht so intuitiv oder natürlich genug. Genau an diesem Punkt setzt meine Forschung an. In der Vergangenheit gab es auch noch andere Einschränkungen. Wenn man sich die Bandbreite der Assistenz-Robotik vorstellt, waren das häufig starre, große und schwere Systeme. Das ist heute zum Glück anders. Es gibt zum Beispiel neue Forschung, die durch den Einsatz intelligenter Materialien auch Hardware und Aktuatorik – also eine Art eingebauter Motor – direkt in die Kleidung integriert.

Hertie Institut für klinische Hirnforschung

Das Hertie-Institut für klinische Hirnforschung (HIH) bildet mit der Neurologischen Universitätsklinik Tübingen das Hertie-Zentrum für Neurologie, eine der größten und modernsten Einrichtungen für klinische Hirnforschung bundesweit. Um die Einheit von Forschung und Patientenversorgung zu betonen, wurde das Zentrum für Neurologie 2023 in „Hertie-Zentrum für Neurologie“ umbenannt.

Man würde sich dann einen „unterstützenden“ Pullover anziehen...?

Genau, der hat dann weiche Sensoren und Aktuatoren integriert, die unterstützen. Das sieht man von außen auch nicht unbedingt. Ich schaue also zu dem Glas Wasser, fange an die Bewegung durchzuführen, und dann unterstützt mich das System im Pullover automatisch. Mit neuen Materialien passiert in der Forschung gerade viel, und es ist sicherlich sehr wichtig, diesen Aspekt zu berücksichtigen, damit die Akzeptanz tragbarer, robotischer Assistenzsysteme in der Gesellschaft wächst.

Was reizt Sie persönlich am Fachbereich Bio-Robotik? Wie sind Sie dazu gekommen?

Ich fand den Fachbereich Bio-Mechanik und Bio-Robotik schon immer super faszinierend, einfach weil er so vielseitig ist. Da kommen viele Fachbereiche zusammen, wie zum Beispiel Informatik, Physik, Numerik, Regelungstechnik und Neurowissenschaften. Und dann ist da natürlich auch die direkte Anwendung, dass wir tragbare Gesundheitstechnologien entwickeln, die Menschen helfen können, ihre Beweglichkeit und ihre Lebensqualität zu verbessern.

Was meinen Sie, wie lange wird es dauern, bis Ihre Forschung erfolgreich in die Umsetzung kommt?

Mein Projekt ist für die nächsten fünf Jahre angelegt und es wäre sehr schön, noch in dieser Zeit tolle Erfolge zu erzielen.

INFO Das Interview führte Rena Beeg für die Gemeinnützige Hertie-Stiftung